На днях довелось настроить один предустановленный AHV кластер на базе NX G7. После коммутации и запуска утилиты для настройки кластера Foundation, я споткнулся на первом же шаге – ноды не обнаруживались по IPv6. Попробовав некоторые решения из KB и по итогу сославшись на особенность свитчей, решил собрать кластер руками.

Под катом достаточно простой порядок действий.

Дано:

- Несколько предустановленных нод NX серии (Supermicro);

- Все сервера подключены двумя портами 10Gbe к двум коммутаторам. На порты подан trunk, а также указан native vlan в котором будут работать гипервизоры и CMV. Агрегации портов нет;

- Также подключен гигабитный IPMI интерфейс;

- На хостах не прописаны никакие IP-адреса, по сети они недоступны.

Учитывая, что все хосты в моем случае уже предустановлены, задача по сбору кластера сильно облегчается. Понять то, что хосты предустановлены легко – нужно включить сервер и убедиться, что производится запуск гипервизора.

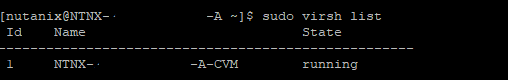

О том, что на гипервизоре запущена CVM также достаточно просто узнать – необходимо войти в систему логином nutanix и паролем nutanix/4u. После этого выполнить команду sudo virsh list

На хосте должна работать виртуальная машина с говорящим суффиксом CVM. Таким образом мы имеем готовые к настройке хосты.

До начала работ необходимо подготовить таблицу формата:

| Node SN | IPMI Addr | AHV Addr | CVM Addr |

| SN-A | 10.100.200.11 | 10.100.201.11 | 10.100.201.31 |

| SN-B | 10.100.200.12 | 10.100.201.12 | 10.100.201.32 |

| SN-C | 10.100.200.13 | 10.100.201.13 | 10.100.201.33 |

Здесь же следует указать используемые маски сети, адреса шлюзов, NTP, DNS. Так же стоит определить заранее адрес под Cluster Management и, возможно, Data Services IP.

Займемся настройкой:

В первую очередь настроим IPMI, чтобы не сидеть в ЦОД. Сделать это можно из консоли, либо через BIOS. Для меня проще настроить IPMI в BIOS, предварительно перезагрузив ноду.

Для подключения к IPMI в случае с серией NX используем логин ADMIN, а в качестве пароля – серийный номер ноды, управление которой мы хотим получить. Найти серийный номер можно на наклейке в задней части ноды.

После настройки IPMI и получения возможности настраивать кластер из удобного места, основным документом, которым следует руководствоваться в настройке, является Acropolis Advanced Administration Guide и раздел Manual Cluster Creation.

Начнем с указания IP адресов гипервизоров AHV. Здесь ничего сложного, привычный CentOS Linux. Меняем адрес на первой ноде в соответствии с инструкцией.

Замена выполняется на созданном предварительно сетевом интерфейсе ifcfg-br0.

На всякий случай сделаем резервную конфигурацию файла настроек интерфейса:ahv$ sudo cp /etc/sysconfig/network-scripts/ifcfg-br0 /root/

Теперь отредактируем файл и зададим адрес, маску и шлюз для гипервизора:ahv$ sudo vi /etc/sysconfig/network-scripts/ifcfg-br0

После правки перезапустим сеть на узле:ahv$ sudo /etc/init.d/network restart

Если все сделано верно, гипервизор должен начать отвечать по сети и станет доступным по SSH.

Теперь укажем внешний IP адрес для CVM, которая работает на данном узле.

Все CVM сконфигурированы с тремя сетевыми интерфейсами: внешний (eth0), внутренний (eth1), а так же интерфейс, который используется при включении Network Segmentation (eth2). Поскольку внешнего IP адреса у нас еще нет, для подключения к CVM используем единственный сконфигурированный – eth1.

Для этого, не уходя далеко с хоста AHV, подключаемся к CVM, которая на нем запущена по SSH (для подключения используем логин nutanix и пароль nutanix/4u:ahv$ ssh nutanix@192.168.5.2

Для смены адреса используем инструкцию. CVM так же работает на CentOS Linux, поэтому большинство шагов аналогичны, в данном случае адрес необходимо задать ТОЛЬКО для интерфейса eth0.

Сделаем резервную копию интерфейса eth0:cvm$ sudo cp /etc/sysconfig/network-scripts/ifcfg-eth0 /root/

Отредактируем файл в соответствии с инструкцией выше:cvm$ sudo vi /etc/sysconfig/network-scripts/ifcfg-eth0

И перезагрузим CVM:cvm$ sudo reboot

Если все сделано верно, после перезагрузки к CVM можно будет подключиться по SSH.

Выполняем аналогичную операцию на всех оставшихся гипервизорах AHV и CVM, которые на них расположены. Как итог, все узлы и CVM должны быть доступны по сети.

Теперь сконфигурируем кластер

Для этого подключаемся к одной из CVM по SSH учетной записью nutanix и запускаем процедуру конфигурации кластера:cvm$ cluster -s 10.10.201.31,10.10.201.32,10.10.201.33 create

Не трудно догадаться, что после ключа -s мы указываем адреса CVM.

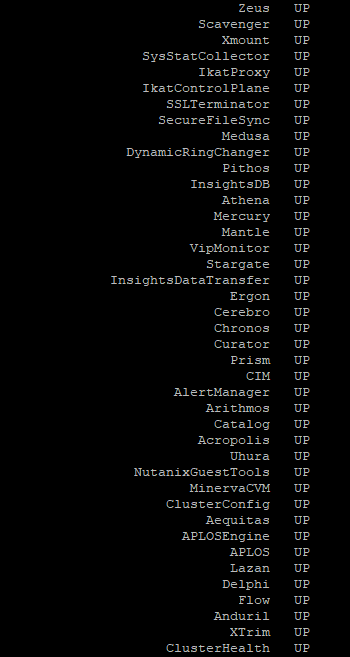

Проблем на этапе конфигурации кластера возникнуть не должно и как итог мы увидим: “INFO cluster:2875 Success!”

При запросе cluster status, мы должны убедиться, что все службы запущены на всех CVM:

Осталось пару штрихов (все операции выполняются с CVM)

Зададим имя кластеру:cvm$ ncli cluster edit-params new-name=cluster_name

Укажем, какие DNS сервера использовать (через запятую):cvm$ ncli cluster add-to-name-servers servers="10.10.10.10,10.10.10.11"

Так же укажем сервера времени NTP:cvm$ ncli cluster add-to-ntp-servers servers="10.10.11.10,10.10.11.11,10.10.11.12"

Возможно, для отображения корректного времени понадобится сменить часовой пояс:cvm$ ncli cluster set-timezone timezone=Asia/Almaty

И зададим адрес для доступа к кластеру, который был определен ранее:cvm$ ncli cluster set-external-ip-address external-ip-address="10.100.201.10"

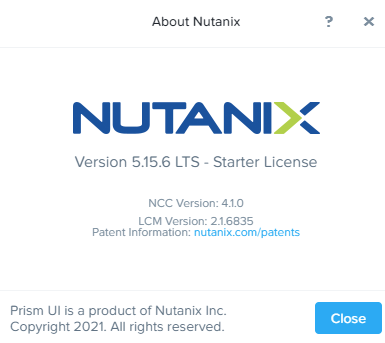

Если подключиться к данному адресу браузером по порту 9440, мы попадем в Prism Element.

При первом входе следует использовать логин admin и пароль nutanix/4u, после чего пароль необходимо будет сменить.

И как итог, мы получаем готовый к использованию кластер:

Вот так, достаточно просто, можно собрать кластер с предварительно установленными гипервизорами без использования Foundation.

![]()

Не думал что такое поддерживается, хотя процесс почти не отличается от установки CE.