Как сказано в документации: Foundation – это основное средство развертывания кластеров Nutanix. Данное программное обеспечение позволяет конфигурировать кластера Nutanix на этапе их развертывания и очень сильно ускоряет процесс настройки и ввода в эксплуатацию.

Для сравнения, ранее я писал про процедуру ручной конфигурации кластера, когда возможности использовать Foundation нет.

Под катом мы посмотрим на процедуру конфигурации кластера из 6 узлов с помощью Foundation VM.

Важно: данная статья применима к оборудованию Nutanix серии NX с предустановленным гипервизором AHV.

Перед началом настройки необходимо выполнить ряд подготовительных работ:

- Определиться с местом размещения оборудования и смонтировать его в стойку, подключить к питанию;

- Выполнить подключение узлов к коммутаторам передачи данных, а также произвести подключение IPMI портов;

- Выделить маршрутизируемую сеть и определить номер VLAN, в котором будут располагаться гипервизоры AHV и CVM;

- Прописать trunk на портах подключения узлов, а также указать Native VLAN для AHV/CVM, определенный ранее;

- Опционально: настроить LACP на портах;

- Опционально: настроить IPMI через BIOS для возможности удаленного подключения к узлам и не проводить настройки из ЦОД.

Заранее стоит подготовить таблицу IP-адресов, которые будут использоваться для AHV/CVM/IPMI:

| Node SN | IPMI Addr | AHV Addr | CVM Addr |

| SN-A | 10.100.200.11 | 10.100.201.11 | 10.100.201.31 |

| SN-B | 10.100.200.12 | 10.100.201.12 | 10.100.201.32 |

| SN-C | 10.100.200.13 | 10.100.201.13 | 10.100.201.33 |

Также следует определить адреса для Cluster IP, для Data Services IP, адреса серверов DNS и NTP.

Все вышеуказанные данные потребуются для дальнейшей настройки и конфигурации узлов и кластера.

Мои условия в которых производилась конфигурация кластера:

- Все узлы идут с предустановленным «на заводе» гипервизором AHV, на узлах уже работает CVM;

- Узлы подключены к двум сетевым коммутаторам, а также к IPMI;

- Для гипервизоров и CVM выделена маршрутизируемая сеть;

- На портах, к которым подключены узлы, настроен LACP, включена опция LACP Fallback;

- На портах, к которым подключены узлы, прописан trunk, в качестве Native VLAN указан VLAN в котором работает выделенная для AHV/CVM сеть;

- IPMI интерфейс на всех узлах настроен через BIOS на этапе монтажа и подключения оборудования.

Теперь, когда все оборудование запущено, подключено к сети, а IPMI работает и доступен, можно приступать к настройке.

Нетрудно догадаться, что настройка будет выполняться с помощью Foundation. В моем случае через Foundation VM. Foundation VM – это заранее подготовленный Nutanix образ с необходимым программным обеспечением, который можно развернуть на AHV, ESXi, либо VirtualBox.

В качестве альтернативы доступны инсталляторы для Widows и MacOS.

Скачать Foundation можно на портале Nutanix в секции Downloads – Foundation.

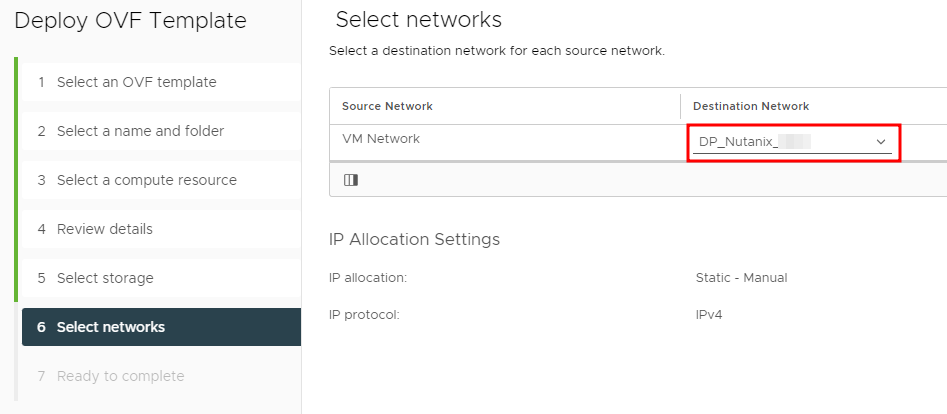

Foundation VM в моем случае разворачивается в кластере VMware. Главное условие – данная виртуальная машина должна быть подключена к той же сети (VLAN), которая определена для AHV и CVM и ее IP адрес не должен пересекаться с адресами, которые были определены ранее для нужд AHV/CVM.

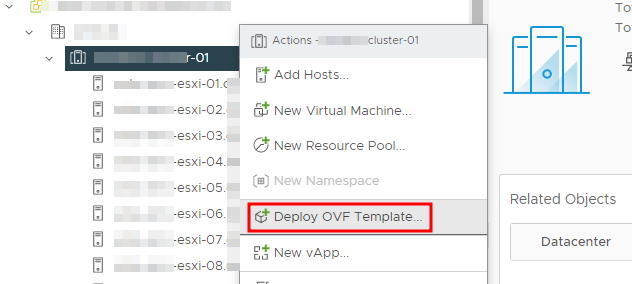

Загружаем образ с портала и разворачиваем его в кластере VMware из OVF. Процесс стандартный:

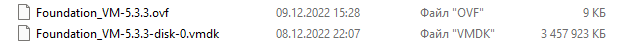

Выбираем два файла, Foundation_VM-xxx.ovf, а так же Foundation_VM-xxx-disk-0.vmdk нажатием Upload Files:

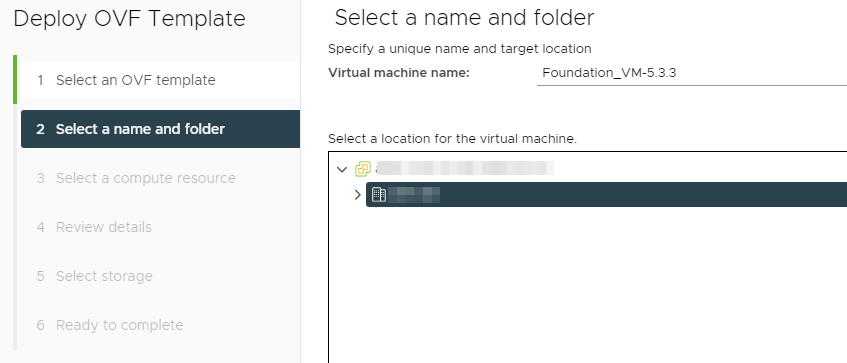

Указываем название VM и папку для размещения:

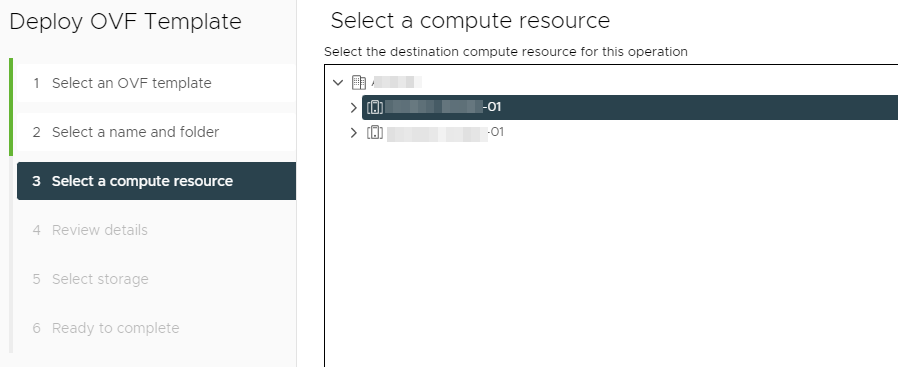

Выбираем кластер, в котором данная VM будет развернута:

Затем указываем хранилище для размещения VM и, заключительным этапом, выбираем сеть, к которой VM будет подключена:

Напомню, что в этой же сети будет работать оборудование Nutanix.

Завершаем процедуру развертывания виртуальной машины, запускаем и получаем готовую к работе систему под управлением CentOS 7.

В первую очередь необходимо IP адрес. С данной сети у меня должны быть доступны как узлы Nutanix, так и их управляющие интерфейсы.

Прописать адрес можно через консоль, либо быстрее, через GUI. System – Preferences – Network Connections:

Задаем адрес, маску и шлюз интерфейса Wired connection 1:

Данный адрес располагается в той же сети, где будут располагаться AHV и CVM в дальнейшем, но он, конечно, не должен с ними пересекаться.

На данном моменте настройка Foundation VM закончена. Можно приступить к конфигурации кластера.

Начать процедуру можно кликом по иконке Nutanix Foundation на рабочем столе:

Далее нас ожидает ряд предварительных настроек.

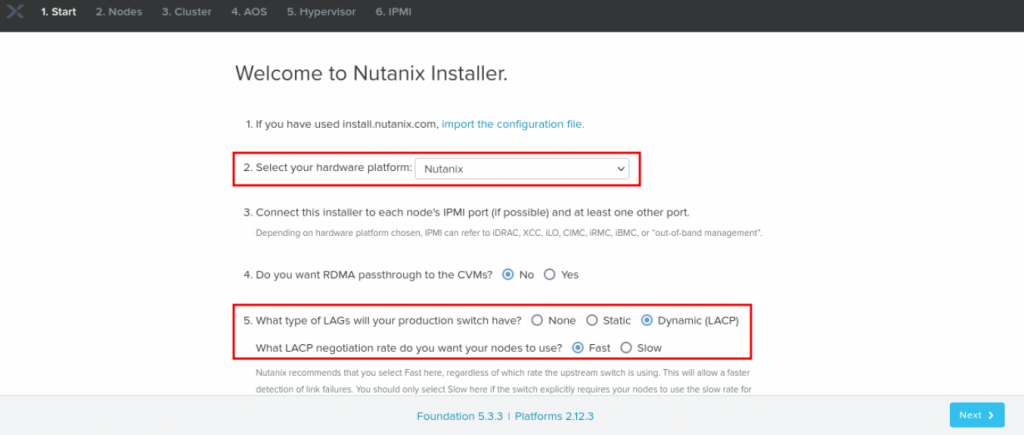

Секция Start.

Первым шагом выбираем Hardware Platform – В моем случае это оборудование Nutanix серии NX.

Далее указывается необходимость в использовании RDMA passthrough. В моем случае – нет.

Ниже я указываю используемую конфигурацию сетевых свитчей. У меня это LACP – Fast.

Далее мы можем задать VLAN для гипервизоров и CVM, но в случае использования Native VLAN делать этого не нужно.

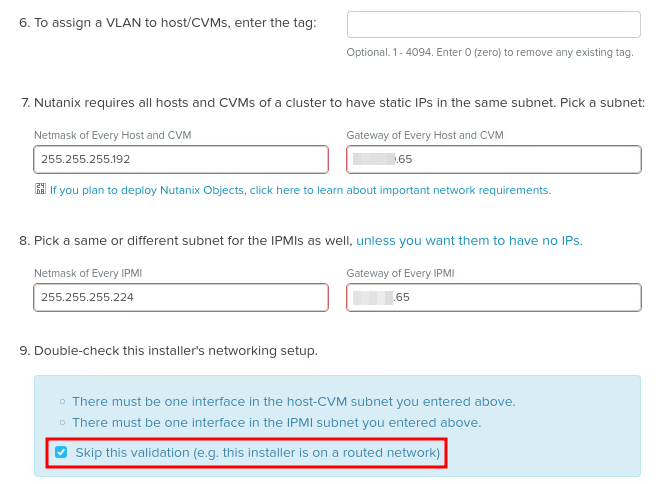

В пунктах 7 и 8 задаются маски подсети, а также адреса шлюзов, которые будут использованы для AHV и CVM, а также для IPMI.

Заключительным шагом на данном этапе настройки необходимо сконфигурировать сетевые интерфейсы Foundation VM, с которых машина будет получать доступ к сети с AHV/CVM и к сети с IPMI. Поскольку моя машина находится в маршрутизируемой сети и имеет доступ и к сети с гипервизорами и к сети с IPMI, данный этап настройки я пропускаю соответствующей галкой:

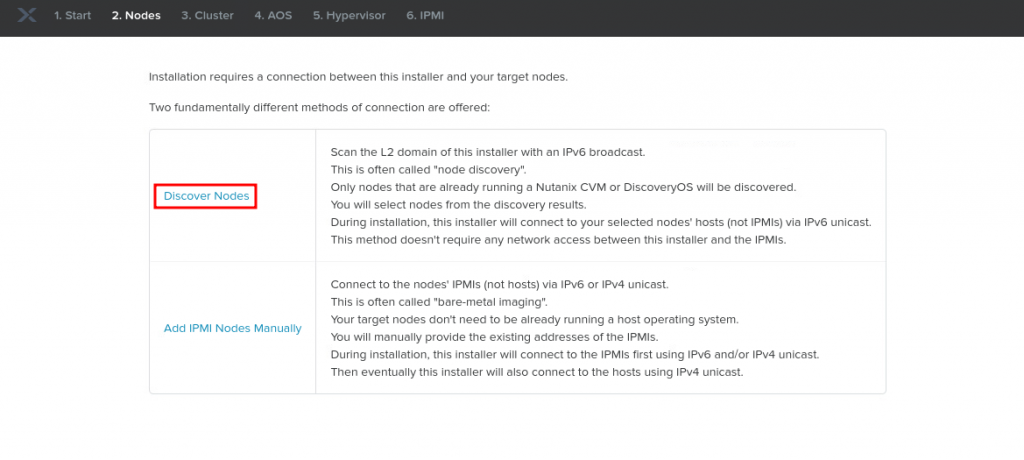

Секция Nodes.

Здесь у нас есть два варианта:

Discover Nodes – мой случай. Когда все гипервизоры запущены, а CVM на них в рабочем состоянии;

Add IPMI Nodes Manually – для Bare-Metal развертываний, в случаях, когда узлы не были предварительно установлены.

Я выбираю первый вариант:

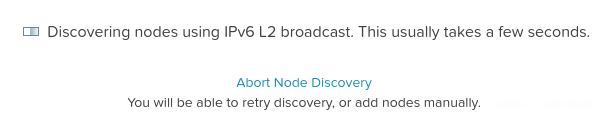

Foundation начнет поиск готовых к настройке узлов в доступном для него L2 домене:

Через некоторое время Foundation обнаружит все узлы, доступные к настройке. Если какие-то узлы не отображаются, хотя должны, стоит проверить их сетевое подключение, а также состояние CVM.

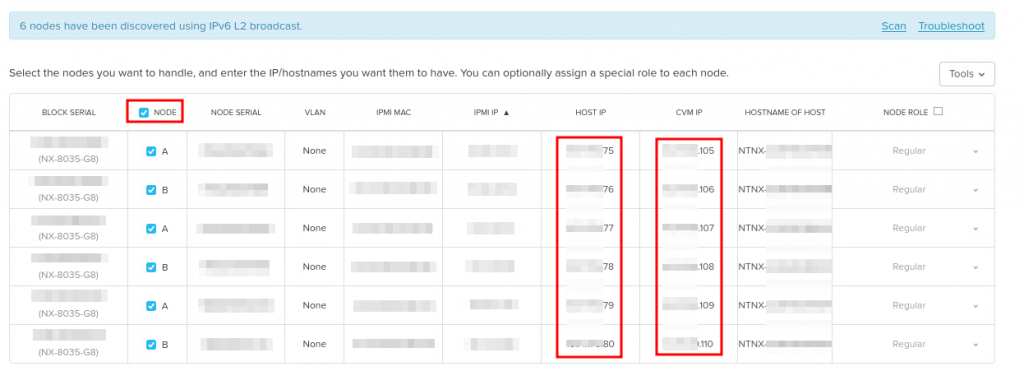

В полученном списке отмечаем узлы для дальнейшей настройки и задаем HOST IP и CVM IP. Настройка IPMI в моем случае не требуется, поскольку уже выполнена ранее:

Здесь же можно задать роль узла – это может быть, как Compute Only, так и Storage Only.

Таким образом мы указали IP адресацию для узлов будущего кластера.

Секция Cluster.

Указываем название кластера и часовой пояс. При необходимости можно сразу же изменить Redundancy Factor.

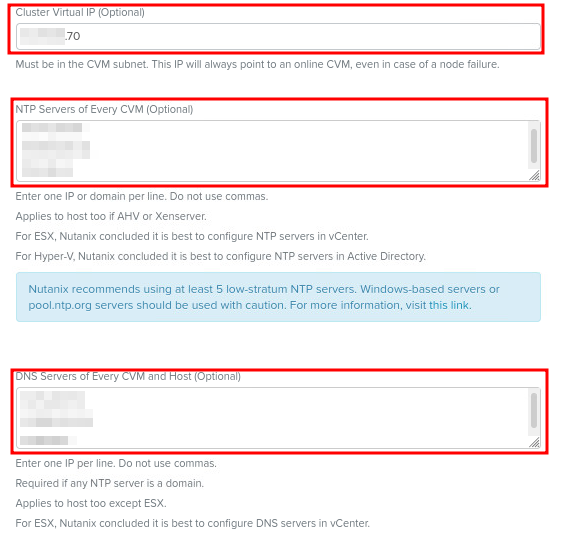

Задаем Cluster Virtual IP, NTP и DNS. Адреса NTP и DNS (каждый адрес с новой строки):

В завершении можно указать объем оперативной памяти, который будет выделен для CVM. Объем памяти напрямую зависит от планируемого используемого функционала в кластере:

Данным этапом настройки мы избавили себя от необходимости выполнять следующие настройки в кластере в последующем.

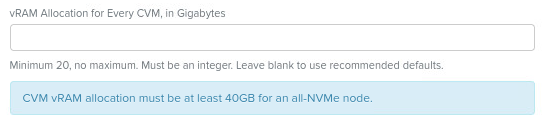

Далее идет проверка версий AOS на узлах, которые ожидаемо должны быть идентичными:

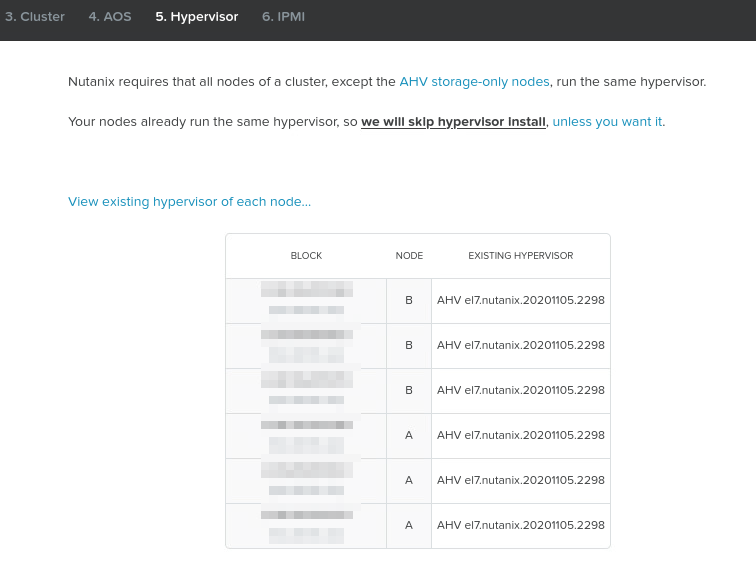

А также версии AHV:

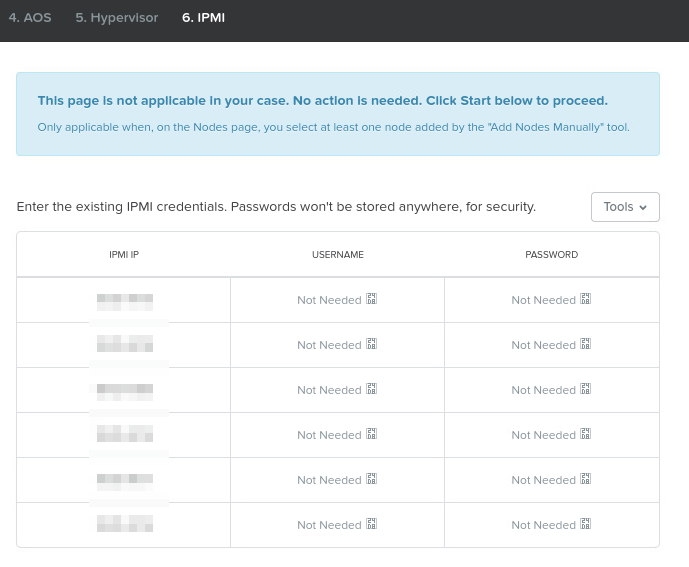

В случае использования настройки через IPMI, может потребоваться указать логины\пароли для доступа Foundation к интерфейсу управления узлами, но это не мой случай. Изначально, пароль для доступа к IPMI – серийный номер узла.

После указания всех настроек, нажимаем кнопку Start, после чего запускается конфигурация узлов и кластера. Foundation просит нас убедиться, что машина не уйдет в спящий режим:

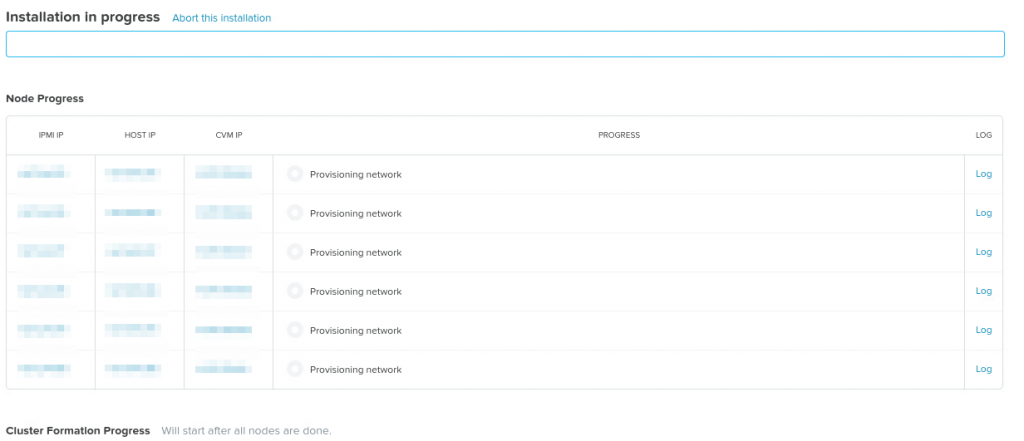

Первым этапом выполняется настройка сети на CVM и гипервизорах. Данный процесс может занять некоторое время:

Если кажется, что что-то идет не так, всегда можно кликнуть по Log в правой части и ознакомиться с журналом текущих событий и действий.

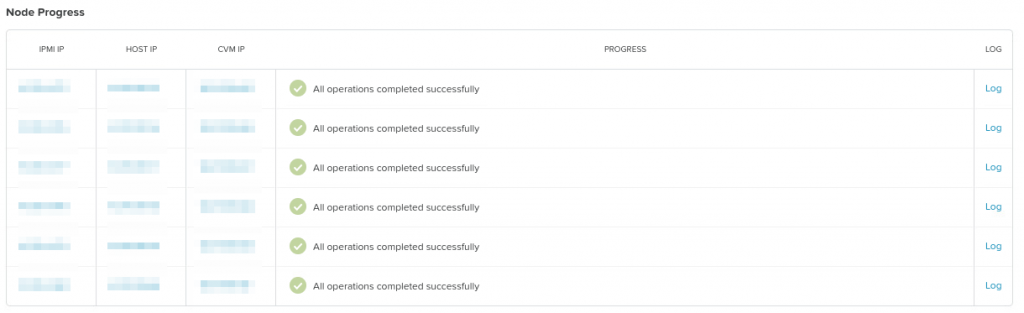

Если конфигурация узлов выполнена корректно, статус операции изменится, соответственно. При желании их можно “попинговать” и проверить доступ по SSH:

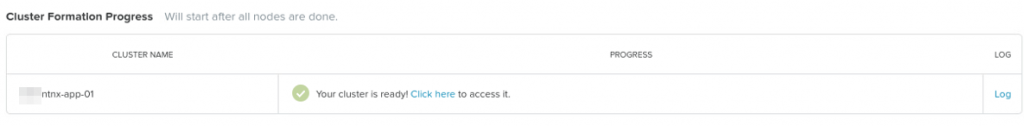

После настройки узлов, запустится процедура формирования кластера, которая также должна завершиться успешно:

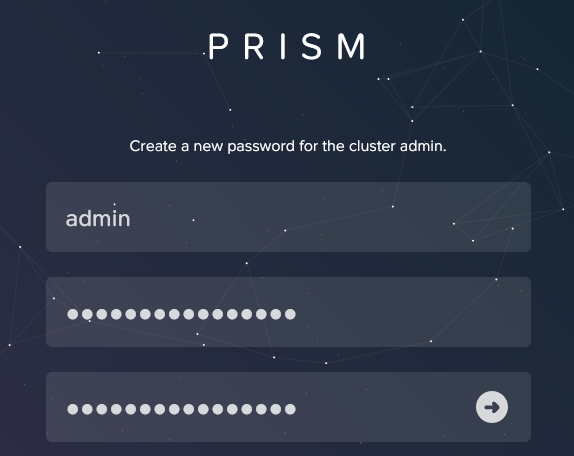

Теперь можно подключиться к Cluster Virtual IP и авторизоваться пользователем admin с паролем по умолчанию nutanix/4u. Пароль потребуется сменить:

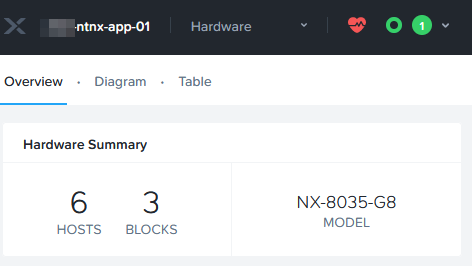

И вот кластер из 6 узлов готов к использованию:

![]()