Не так давно вышел релиз Nutanix Community Edition 2.0 (CE 2.0), который основан на базе Nutanix AOS 6.5 – самой актуальной LTS версии на момент написания статьи.

Далее мы внимательно посмотрим на процедуру развертывания кластера Nutanix CE 2.0 из трех узлов в инфраструктуре VMware vSphere 8.

До того, как мы приступим к развертыванию и настройке, давайте посмотрим на основные существующие требования и ограничения.

Процессор:

Процессоры с поддержкой Intel VT-x, либо процессоры семейства AMD с архитектурой Zen Micro и выше.

Минимальный процессор должен иметь 4 ядра, из которых 2 выделяется CVM.

ОЗУ:

Минимум 20GB. Но, чем больше функционала и виртуальных машин планируется использовать – тем больше ОЗУ может потребоваться. Для использования большинства функций AOS рекомендуется 32GB и выше.

Жесткие диски:

Максимальное количество – 4 HDD/SSD на узел, но отмечается, что некоторые пользователи сообщали об успешном использовании и большего количества дисков.

Cold Tier – 500GB и выше;

Hot Tier – 200GB и выше – SSD.

Так же необходим отдельный диск объемом от 32GB на который будет установлен гипервизор. Это может быть, как USB, так и SATA DOM, M.2 SSD и т.п.

Рекомендуются надежные диски, способные выдерживать интенсивные нагрузки.

Кластер:

Кластер может состоять из 1 узла (Single-Node), а также из 3 или 4 узлов. Максимальный размер кластера – 4 узла.

Обратите внимание, что, если на этапе инсталляции был выбран Single-Node кластер, расширить его в дальнейшем до трех узлов не получится.

Гипервизор ESXi официально не поддерживается.

Прочие требования:

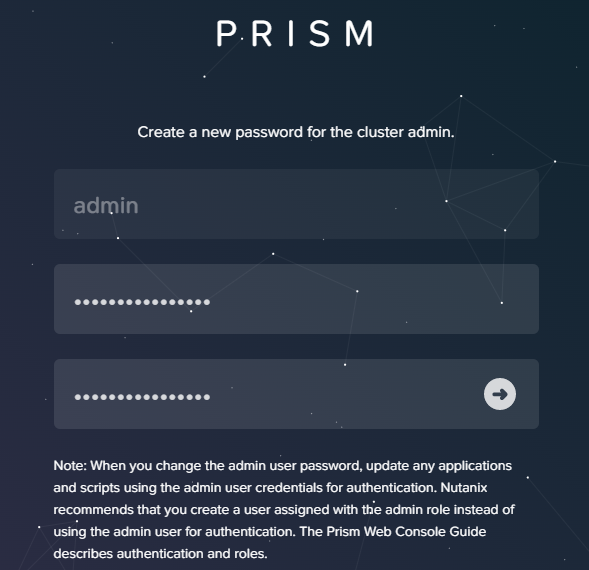

1. Пароль администратора обязательно должен быть изменен при первом входе в Prism;

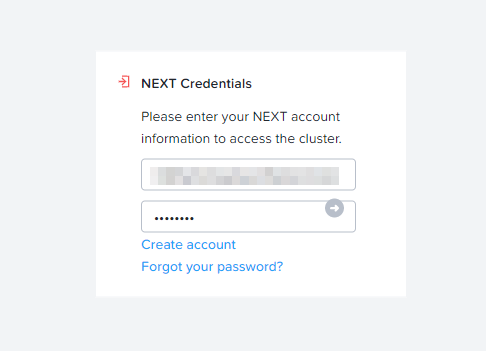

2. При первом входе в Prism необходимо будет указать аккаунт с ранее пройденной регистрацией в .NEXT (об этом далее);

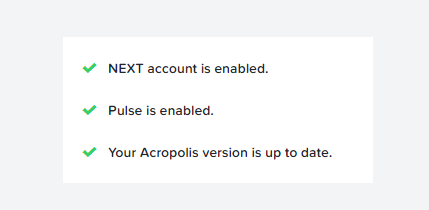

3. Должны быть открыты исходящие порты 80 и 8443 для работы Pulse, который отправляет статистику в Nutanix, такую как возникающие в кластере ошибки, и статику использования.

Когда мы разобрались с требованиями приступим к установке.

В первую очередь необходимо зарегистрироваться по ссылке и создать учетную запись.

Далее, на портале Next Nutanix, скачиваем ISO файл phoenix-ce2.0-fraser-6.5.2-stable-fnd-5.3.4-x86_64.iso, содержащий установочные файлы CE 2.0.

Когда все установочные файлы загружены. Можно заняться подготовкой виртуальной инфраструктуры и машин.

Прежде всего, необходимо заранее определиться с сетью и IP-адресацией. Для развертывания кластера из 3 узлов, минимально необходимое количество адресов – 7.

3 адреса будут задействованы под гипервизор AHV;

3 адреса будут задействованы для CVM;

1 адрес для Cluster IP.

Так же заранее стоит позаботиться об IP адресах для Data Services IP и для Prism Central, если планируется использовать в дальнейшем.

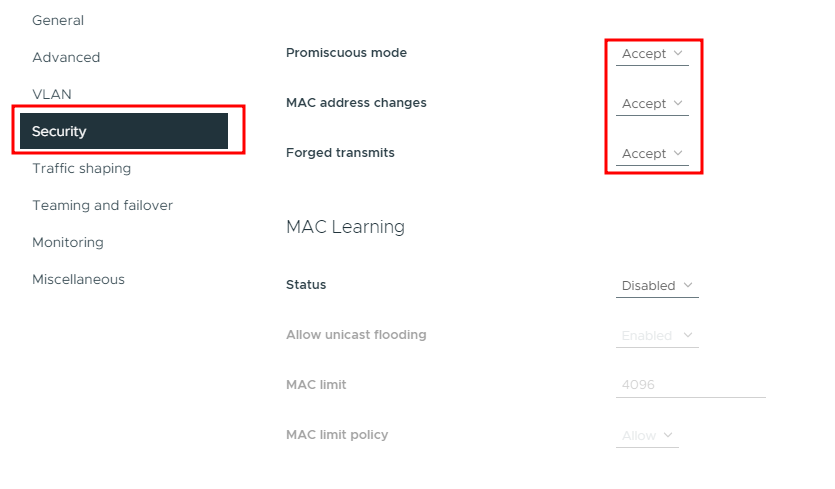

В виртуальной инфраструктуре первым шагом необходимо создать сеть, к которой будут подключены виртуальные машины Nutanix CE 2.0. Основной момент, которому нужно уделить внимание – это перевод Promiscuous mode, Mac address changes и Forged transmits в режим Accept:

Сеть может быть создана как на стандартном свитче, так и на распределенном. В моем примере используется распределенный свитч.

Далее займемся подготовкой трех виртуальных машин. Я не буду описывать весь процесс создания VM, но заострю внимание на некоторых важных моментах.

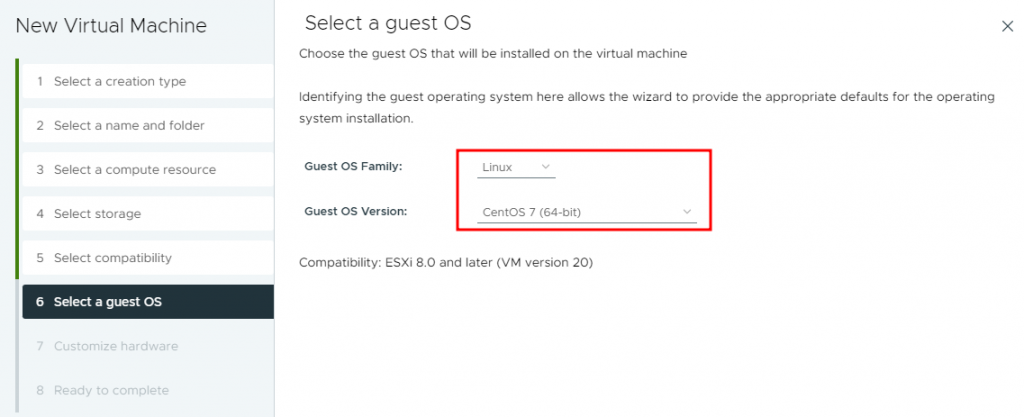

В качестве Guest OS я выбираю Linux – CentOS 7 (64-Bit):

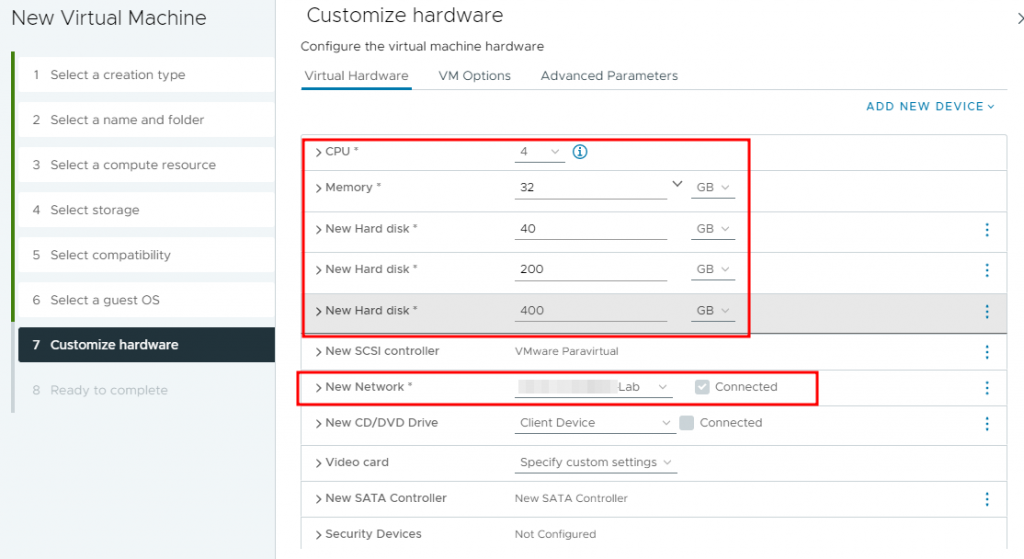

На этапе Customize hardware, выделяем необходимое количество процессорных ресурсов и оперативной памяти. Не забываем выбрать нужную сеть.

А также добавляем 3 диска:

В моем случае Hard Disk 1 – для установки гипервизора;

Hard Disk 2 – Hot Tier (быстрое хранилище);

Hard Disk 3 – Cold Tier (медленное хранилище).

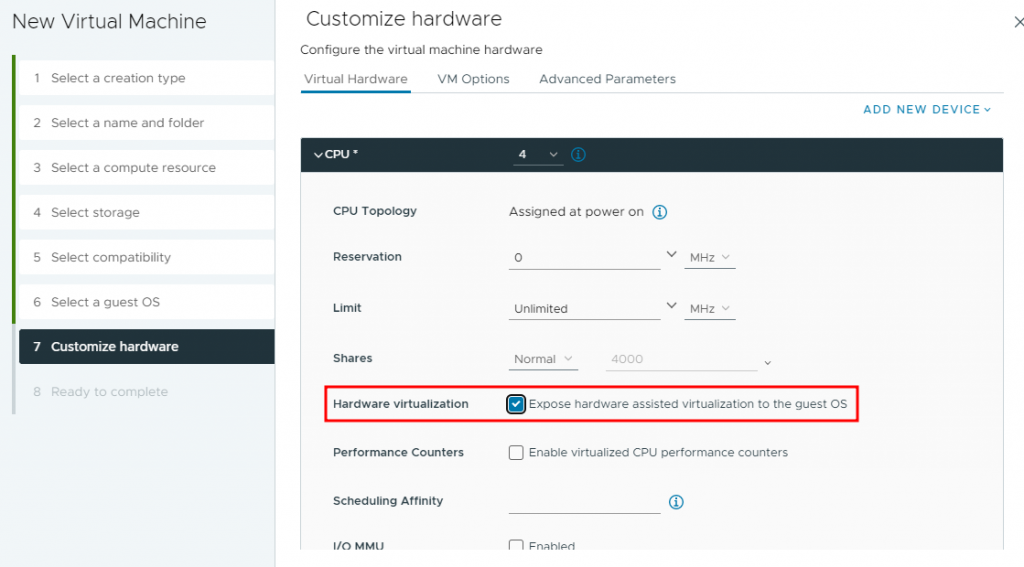

Разворачиваем вкладку CPU и включаем Hardware virtualization – Expose hardware assisted virtualization to the guest OS:

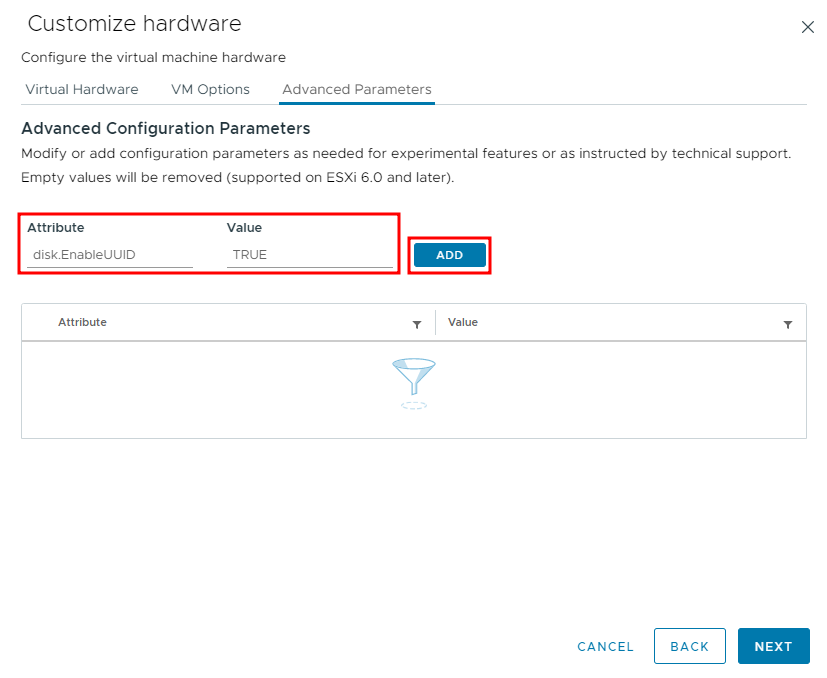

Перемещаемся из вкладки Virtual Hardware на вкладку Advanced Parameters и добавляем параметр disk.EnableUUID = TRUE:

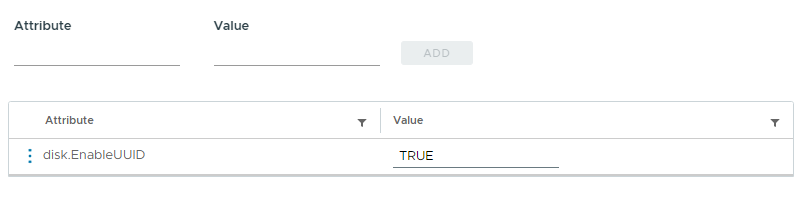

Итоговый результат добавленного параметра выглядит следующим образом:

Необходимость в данном параметре я описал в статье вышедшей ранее.

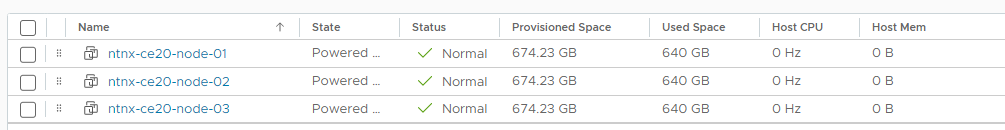

На этом процесс подготовки виртуальной машины закончен. В итоге должно получиться 3 одинаково сконфигурированных VM:

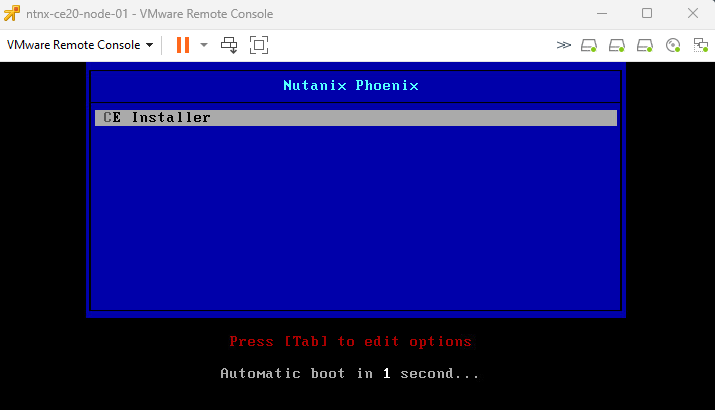

Запускаем виртуальные машины, подключаем скачанный ранее ISO файл, после чего ожидаемо должен загрузиться установщик Nutanix CE:

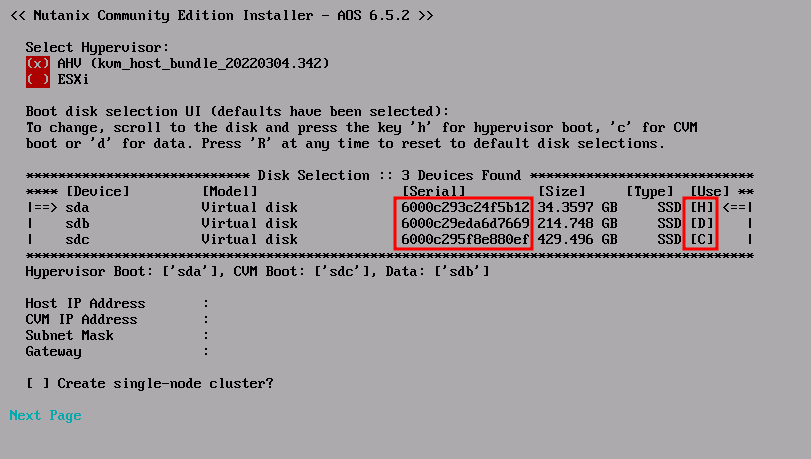

На первом этапе установки необходимо обратить внимание на следующие моменты:

У дисков должно корректно отображается поле Serial. Если это не так, следует убедиться в наличии параметра disk.EnableUUID в значении True у VM.

Так же напротив дисков можно увидеть метки H, C, D.

H – диск, на который будет установлен гипервизор;

C – диск для CVM, Hot Tier, обычно более быстрый;

D – диск для данных.

Изначально наиболее объемный выбирается для CVM. Изменить это достаточно просто. С помощью кнопки Tab можно переместиться в раздел дисков и клавишами h, c, d выбрать нужные диски.

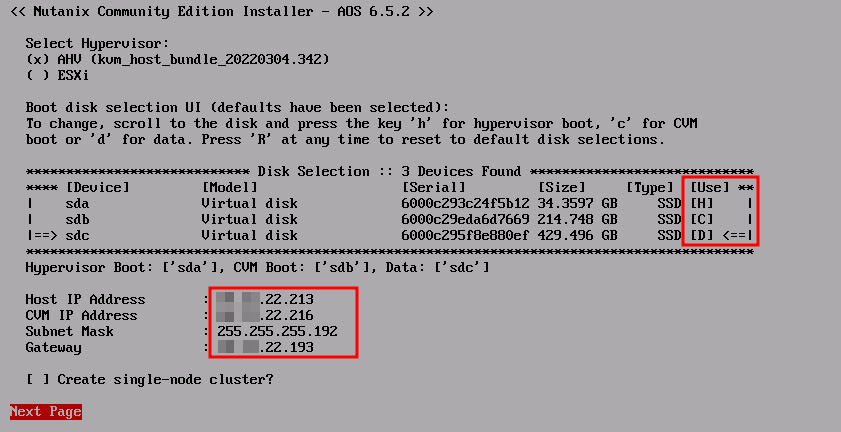

Так же с помощью Tab перемещаемся ниже и задаем IP адреса AHV, CVM:

Таким образом в примере выше я выбрал диск на 214GB для CVM (Буква C в поле Use) и диск на 429GB для Extent Store (Буква D, соответственно). Так же я задал IP адреса гипервизора и CVM, маску и шлюз. Обратите внимание, что гипервизор и CVM должны располагаться в одной сети.

Поскольку мы создаем кластер из трех узлов, отметку «Create single-node cluster?» ставить не нужно.

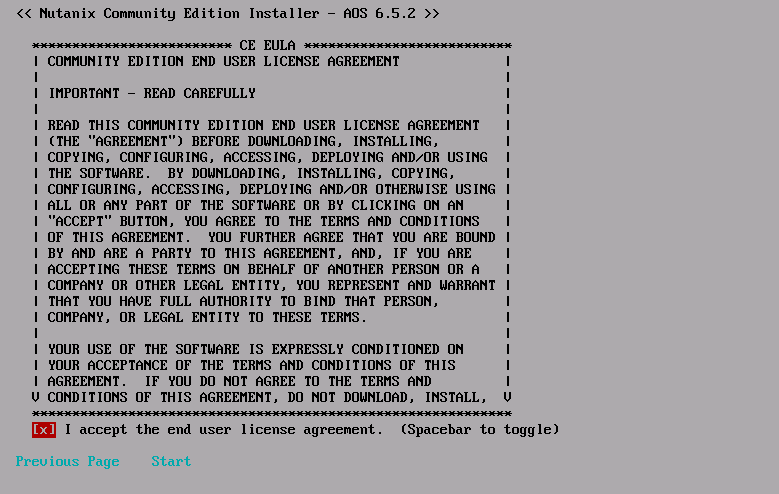

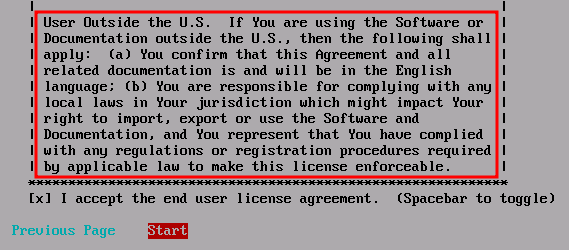

Переходим на следующий экран, где нужно ознакомиться с лицензионным соглашением и принять его:

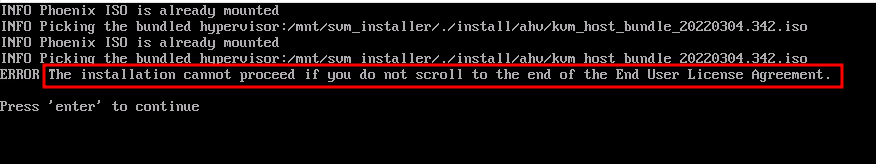

По нажатию на Start начнется инсталляция, однако, если лицензионное сообщение не было дочитано до конца, можно встретить соответствующую ошибку:

По нажатию enter, мы вернемся на шаг назад и ознакомимся с лицензионным соглашением до конца:

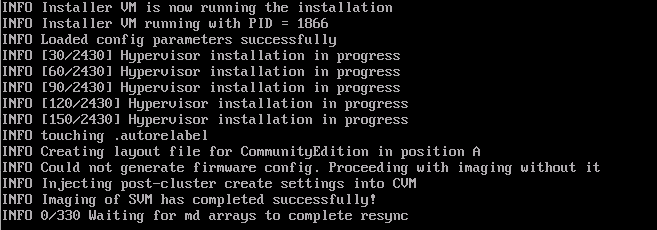

Теперь процедура установки будет запущена:

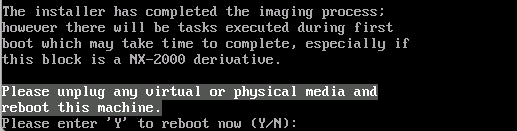

Дожидаемся окончания, отключаем ISO образ и нажимаем «Y» для перезагрузки узла:

Аналогичным образом, устанавливаются два оставшихся сервера. Как итоговый результат работы, мы должны получить 3 сервера с установленным гипервизором Nutanix AHV и работающими на них CVM.

И AHV и CVM должны отвечать на ping, если они не отвечают, следует проверить корректность настройки сети в виртуальном свитче, а так же состояние CVM на хосте.

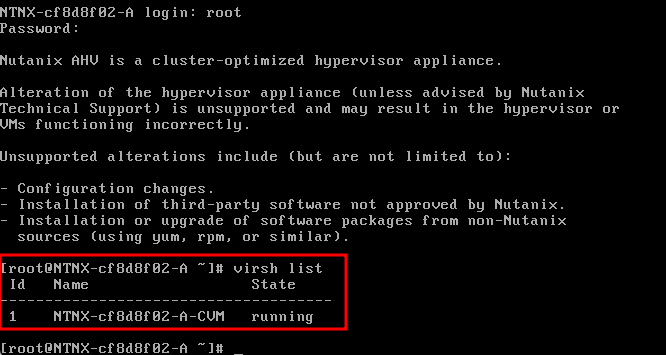

Сделать это можно подключившись к гипервизору с учетными данными root / nutanix/4u, а затем проверить запущенные виртуальные машины с помощью команды virsh list:

Ожидается, что на каждом из трех узлов должна работать одна виртуальная машина CVM.

При необходимости дальнейшего траблшутинга, можно подключиться к CVM непосредственно с гипервизора по SSH:

ssh nutanix@192.168.5.254Пароль в данном случае аналогичный – nutanix/4u.

Создание и конфигурация кластера.

После того, как все виртуальные машины готовы, установка CE 2.0 проведена, а гипервизоры и CVM доступны из сети. Можно приступить к конфигурации кластера.

Выполнить конфигурацию кластера можно подключившись к любой из CVM по SSH. Логин: nutanix, пароль: nutanix/4u

Запустим процедуру создания кластера:

nutanix@CVM:~$ cluster -s 192.168.22.214,192.168.22.215,192.168.22.216 createЧерез запятую указываются IP-адреса CVM, которые должны стать членами кластера.

Дожидаемся окончания процедуры формирования кластера и запуска сервисов. Как результат должно быть выведено что-то похожее на:

INFO cluster:2875 Success!Проверим статус кластера командой cluster status:

CVM: 192.168.22.214 Up

Zeus UP [12963, 13052, 13053, 13123, 13139, 13157]

Scavenger UP [15569, 15671, 15672, 15673]

Xmount UP [15566, 15641, 15642, 15822]

SysStatCollector UP [19469, 19547, 19548, 19549]

IkatProxy UP [20154, 20223, 20224, 20225]

IkatControlPlane UP [20443, 20515, 20516, 20517]

SSLTerminator UP [20463, 20571, 20572]

SecureFileSync UP [20484, 20621, 20622, 20623]

Medusa UP [20879, 20994, 20995, 21014, 21261]

DynamicRingChanger UP [21518, 21576, 21577, 21589]

Pithos UP [21540, 21669, 21670, 21680]

InsightsDB UP [21599, 21821, 21822, 21913]

Athena UP [21672, 21998, 21999, 22000]

Mercury UP [30468, 30532, 30533, 30539]

Mantle UP [22134, 22355, 22356, 22366]

VipMonitor UP [24211, 24212, 24213, 24214, 24219]

Stargate UP [22651, 22699, 22700, 22711, 22712]

InsightsDataTransfer UP [22937, 23046, 23047, 23050, 23051, 23052, 23053, 23054, 23055]

Ergon UP [22971, 23184, 23185, 23758]

GoErgon UP [22996, 23213, 23214, 23237]

Cerebro UP [23267, 23405, 23406, 23490]

Chronos UP [23328, 23471, 23472, 23476]

Curator UP [23424, 23582, 23583, 23626]

Prism UP [23616, 23839, 23840, 23856]

Hera UP [23722, 23991, 23992, 23993]

CIM UP [23802, 24074, 24075, 24077, 24088]

AlertManager UP [24034, 24580, 24581, 24613]

Arithmos UP [24471, 24825, 24826, 24849]

Catalog UP [24952, 25180, 25181, 25182, 25193]

Acropolis UP [25403, 25531, 25532, 29238]

Uhura UP [25450, 25589, 25590, 28171]

NutanixGuestTools UP [25546, 25670, 25671, 25677, 25694]

MinervaCVM UP [26988, 27090, 27091, 27092, 27276]

ClusterConfig UP [27009, 27184, 27185, 27186]

APLOSEngine UP [27094, 27245, 27246, 27247]

APLOS UP [28337, 28447, 28448, 28450]

PlacementSolver UP [28381, 28524, 28525, 28526]

Lazan UP [28486, 28674, 28675, 28676]

Polaris UP [28565, 28845, 28846, 28876]

Delphi UP [28729, 28975, 28976, 28977]

Security UP [28981, 29352, 29353, 29354]

Flow UP [29435, 29585, 29586, 29587]

Anduril UP [29503, 29634, 29635, 29636]

XTrim UP [29650, 29713, 29714, 29715]

ClusterHealth UP [27149, 27173, 27174, 27510, 27531, 27532, 27533, 27535, 27536, 27537, 27544, 27546, 27554, 27558, 27564, 27586, 27597, 27660, 27663, 29670, 29801, 29861, 29862, 29864, 29867, 29957, 29958, 29959, 29961, 29962, 29963, 29964, 29968, 29969, 29970, 29973, 29974, 29975, 30111, 30112, 30113, 30114, 30116, 30117]

Успешным результатом будет сообщение о том, что на всех CVM работают все службы.

Если не все службы запущены, попытаться запустить их можно командой cluster start.

Когда кластер создан, выполним некоторые базовые настройки.

Зададим название кластера:

nutanix@CVM:~$ ncli cluster edit-params new-name=ntnx-ce20

Cluster Name : ntnx-ce20Добавим свой DNS сервер:

nutanix@CVM:~$ ncli cluster add-to-name-servers servers="192.168.22.201"

Name Servers : 192.168.22.201, 8.8.8.8, 8.8.4.4Добавим NTP сервера:

nutanix@CVM:~$ ncli cluster add-to-ntp-servers servers="192.168.23.3,192.168.23.4,192.168.23.5"

NTP Servers : 1.pool.ntp.org, 0.pool.ntp.org, 192.168.23.3, 192.168.23.4, 192.168.23.5Как можно заметить, в списке присутствуют внешние NTP-пулы, которые я хотел бы удалить:

nutanix@CVM:~$ ncli cluster remove-from-ntp-servers servers="1.pool.ntp.org,0.pool.ntp.org"

NTP Servers : 192.168.23.3, 192.168.23.4, 192.168.23.5Зададим часовой пояс:

nutanix@CVM:~$ ncli cluster set-timezone timezone=Asia/Almaty

Daily/weekly/monthly DR schedules are impacted by cluster timezone change. Please remove existing daily/weekly/monthly DR schedules before proceeding and reconfigure those schedules later to follow the new timezone. Do you want to continue.(y/N)?: y

Please reboot the CVM or restart all services on the cluster so that logs are timestamped with the new Timezone.

Timezone : Asia/AlmatyПоскольку выход в интернет в данном случае необходим, но прямого доступа нет, я добавлю прокси:

nutanix@CVM:~$ ncli http-proxy add name=vmik-proxy address=192.168.22.201 port=3128 proxy-types=http,https

Status : trueПоследним шагом задаем Cluster IP, по которому будет доступен Web-интерфейс Prism Element:

nutanix@CVM:~$ ncli cluster set-external-ip-address external-ip-address="192.168.22.210"

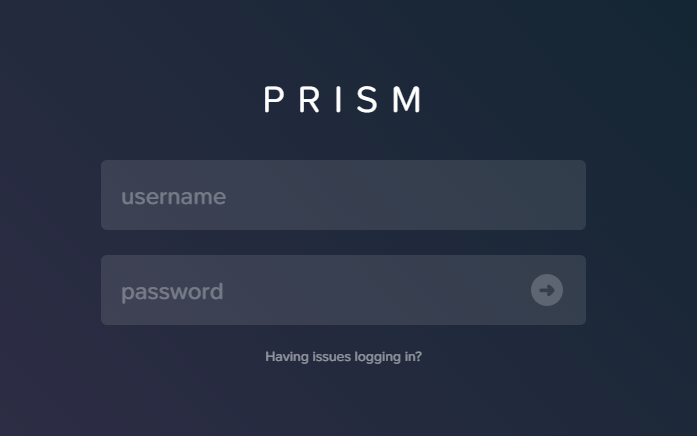

External IP address : 192.168.22.210На этом конфигурация кластера завершена. Открываем веб браузер и переходим по ранее заданному Cluster IP адресу, указав порт 9440. Например, https://192.168.22.210:9440

Добро пожаловать в интерфейс Prism Element:

Авторизуемся учетной записью admin с паролем nutanix/4u, после чего будет предложено сменить пароль:

Авторизуемся с новым паролем. Теперь от нас потребуется указать учетную запись .NEXT, которую мы использовали ранее при процедуре регистрации:

Если учетные данные указаны правильно и в кластере присутствует доступ в интернет, все должно быть в порядке:

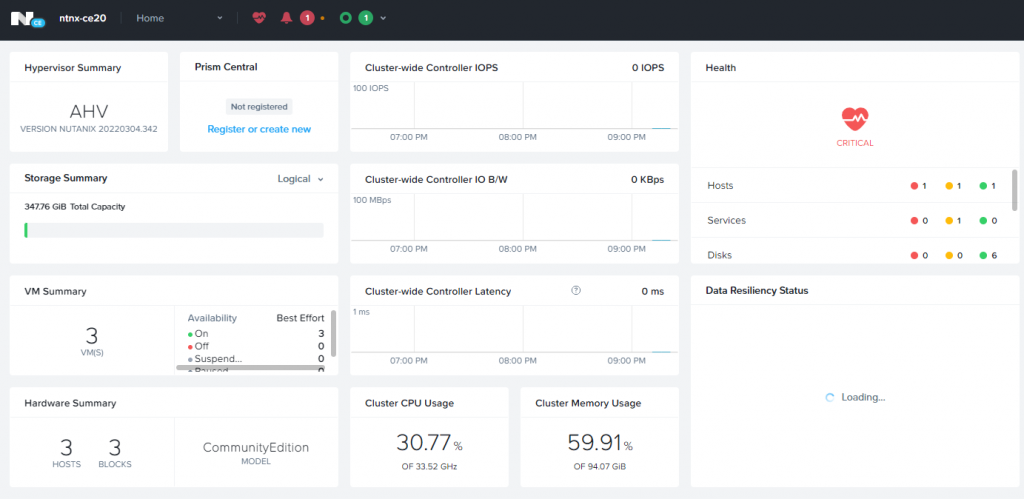

Кластер Nutanix CE 2.0 из трех узлов готов к использованию:

![]()

Thanks for the detailed step-by-step guide. I followed it but got this error:

WARNING MainThread genesis_utils.py:1580 Failed to reach a node where Genesis is up. Ensure Genesis is running on all CVMs. Retrying…(Hit Ctrl-C to abort)

Hello. It really depends.

I believe that you faced this error during the cluster creation step.

Usually, you just need to wait and not rush after deploying all of your nodes.

It depends on the underlying hardware (especially storage) and it can affect the speed of CVM’s processes are starting.

Also, please make sure that your network is fine and that you can ping all of your hosts, CVMs.

Sometimes reinstalling the node can help.

Hello, thanks for your response.

I have been able to deploy a single node cluster. but not able to deploy 3-node cluster.

Hardware is HP DL360 G9. Pretty decent. I previously used it for Nutanix CE 5.18 and this worked fine. Storage is good too, 1 x SSD & several HDDs

I wonder if this is to do with ESXi 7?

thanks

Ike

Hello, after a few tries, I finally got the 3-node cluster up and running.

Had to to genesis restart on all 3 cvms.

Then cluster start a few times before all services came up.

Thanks.

Ike

I’m glad you solved the problem!

Приветствую!

Судя по адресам в статье, каждая нода имеет по 2 адреса? Откуда тогда адрес 192.168.5.254 если все адресак в одно сети должны быть?

Добрый день.

Это внутренний адрес CVM, он доступен только с гипервизора, на котором эта CVM работает.

У меня при попытке загрузить образ Nutanix CE просит серийный номер или сервисный контракт… как его скачать?

Нужно зарегистрироваться на Community портале https://next.nutanix.com/, будет создана учетная запись my.nutanix с ограниченными правами, но насколько я помню, сервисный контракт для этого не нужен.